在人工智能领域,大模型的推理能力一直是研究的焦点。最近,字节跳动推出了ProtoReasoning框架,为大模型推理能力的提升提供了一种全新的解决方案。这个框架通过利用可扩展且可验证的原型表示(例如用于逻辑推理的Prolog和用于规划任务的PDDL),在多种推理任务中都取得了显著的性能提升。

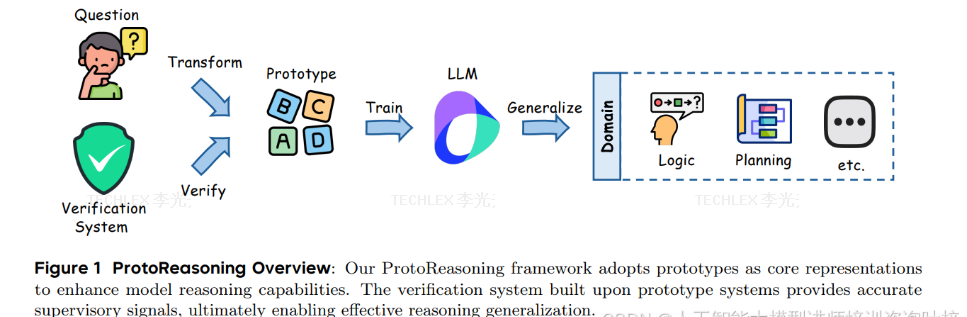

图 1 展示了 ProtoReasoning 框架的整体架构。ProtoReasoning框架的核心思想是基于抽象推理原型来实现跨领域的泛化能力。这些原型是捕捉跨领域问题本质的基本推理模式。通过自动化流程将问题转化为对应的原型表示,模型能够在更抽象的层面上学习推理模式。

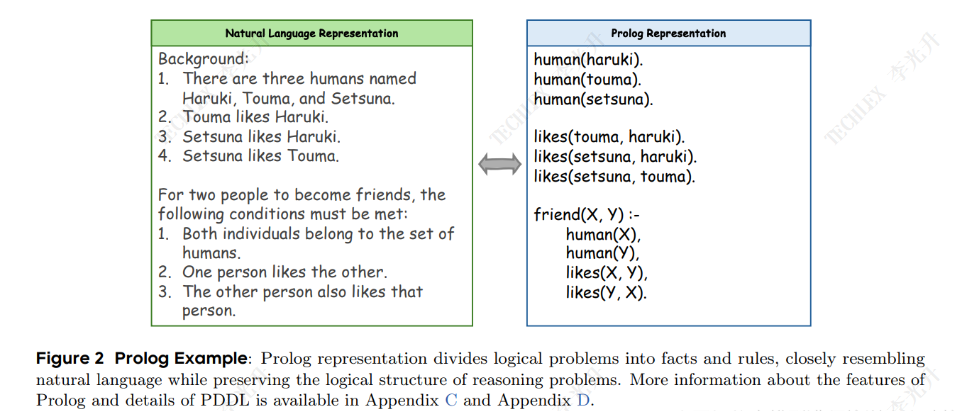

例如,框架采用Prolog作为逻辑推理的原型表示。Prolog是一种基于一阶谓词逻辑的声明式编程语言,具有表达问题的声明性、强大的表达能力和可验证性。论文中的图2展示了一个具体的Prolog示例,图2展示了如何将逻辑问题划分为事实和规则,从而保留推理问题的逻辑结构。通过这种方式,模型可以专注于核心的逻辑关系,而不是繁琐的细节。

对于规划任务,框架采用了PDDL(规划领域定义语言)作为原型表示。PDDL能够通过状态表示、带前提和效果的动作以及状态转移来建模自动规划问题。论文中详细介绍了如何基于PDDL构建原型学习,并提出了三种新颖的任务形式:计划生成、计划完成和计划重排。每种任务类型都有相应的验证系统,以确保生成的计划正确无误。

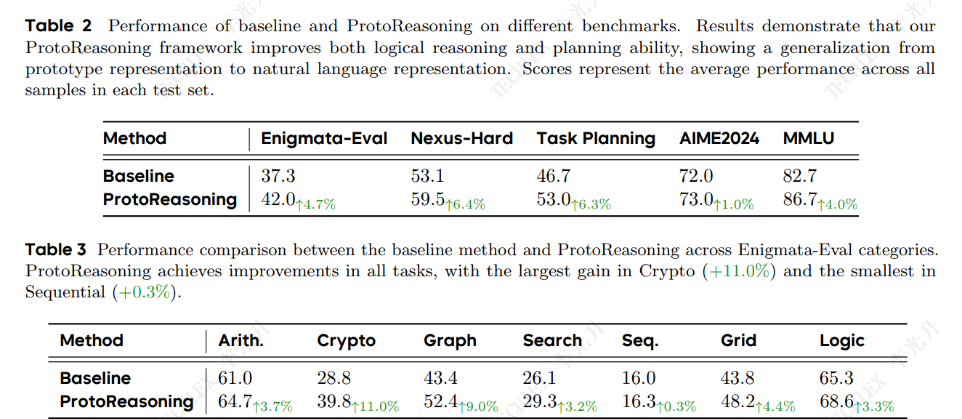

在实验验证方面,论文通过多个推理基准测试展示了ProtoReasoning框架的优势。例如,在逻辑推理的Enigmata-Eval基准测试中,ProtoReasoning相比基线模型提升了4.7%。表2和表3提供了详细的性能对比数据,表2显示在Enigmata-Eval基准测试中,ProtoReasoning将逻辑推理性能从37.3%提升到42.0%,表3则列出了不同推理类别的具体性能提升,如密码推理类别提升了11.0%。这些结果有力地证明了ProtoReasoning框架在提升模型泛化能力方面的优势,尤其是在面对结构相似的问题时,基于原型的训练方法能够取得与直接在自然语言上训练相当甚至更优的性能。